AI myli liczby i stwierdzenia. To badanie pokazuje, że chatboty są dalekie od ideału

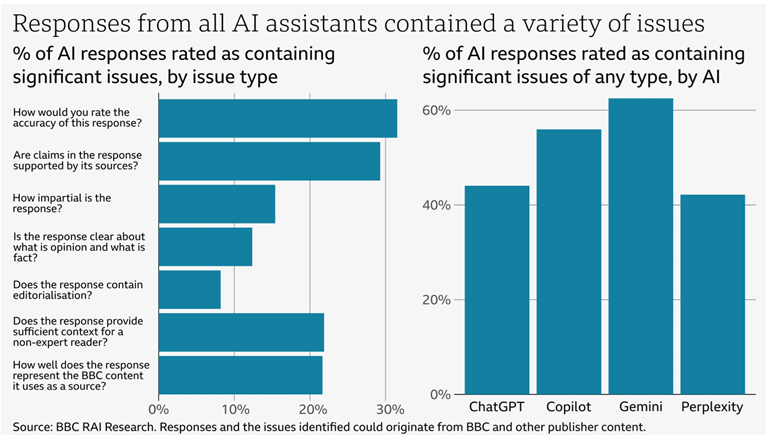

Popularne chatboty bazujące na sztucznej inteligencji manipulują treściami dziennikarskimi, których używają do udzielania odpowiedzi na zapytania użytkowników – wynika z badania BBC. Aż połowa ze wszystkich zbadanych odpowiedzi chatbotów na pytania dotyczące wiadomości zawierała istotne błędy. AI myli liczby, daty czy konkretne stwierdzenia.

BBC zbadało możliwości kilku najpopularniejszych asystentów AI - ChataGPT firmy OpenAI; Copilota od Microsoft; Google Gemini oraz Perplexity. Badacze chcieli dowiedzieć się, że czy chatboty podają odbiorcom dokładne odpowiedzi na pytania dotyczące newsów z BBC. Sprawdzono, jak boty radziły sobie z dokładnością cytowania źródła pierwotnego tekstu, Odpowiedzi AI zostały zweryfikowane przez dziennikarzy BBC, z których każdy był ekspertem w danej dziedzinie.

Zobacz: Dokąd zmierza dziennikarstwo? Raport Reutersa

Aż 91 proc. przeanalizowanych treści zawierała „jakieś” błędy lub nieścisłości. Ponad połowa (51 proc.) zawierała pomyłki „w jakiejś formie”. Najbardziej zawodnym chatbotem okazało się narzędzie Google Gemini, zaś najmniej błędów zwracało Perplexity.

Najmniej błędów przy cytowaniu treści z BBC odnotowano w ChatGPT (15 proc.), Perplexity (17 proc.), Copilotcie (27 proc.) i Gemini (34 proc.).

Jedna piąta odpowiedzi AI, które cytowały treści BBC, zawierało błędy rzeczowe, takie jak niepoprawne stwierdzenia, liczby czy daty. 13 proc. cytatów z artykułów autorstwa BBC zostało zmienionych w stosunku do pierwotnego źródła lub wcale nie było zacytowanych.

Lista błędów nie obejmuje jedynie faktografii – testowane przez BBC chatboty AI miały trudności z rozróżnieniem opinii od faktów, czy uwzględnianiem istotnych kontekstów podawanych informacji, co jest szczególnie ważne w takich tematach jak polityka, światowe konflikty czy medycyna i zdrowie.

Zobacz: Czy ChatGPT daje ruch na stronach mediów? Wydawcy są zgodni

Chatboty problemem, ale i częścią rozwiązania

„Ważne jest, aby odbiorcy mogli ufać w dokładność wiadomości, niezależnie od tego, czy są konsumowane w telewizji, radiu, na platformach cyfrowych lub za pośrednictwem asystenta AI. Ma to znaczenie, ponieważ społeczeństwo opiera się na na rozumieniu przekazywanych faktów, a nieścisłości i zniekształcenia mogą prowadzić do rzeczywistych szkód – wskazują autorzy badania.

„Nasze badania mogą jedynie przybliżyć rozmiar problemu. Nieznana jest skala i zakres wypaczeń i zniekształcenia zaufanych treści (przez chatboty AI – przyp.). Wynika to z faktu, że asystenci AI mogą udzielać odpowiedzi na pytania z szerokiego zakresu tematycznego, a użytkownicy mogą otrzymywać różne odpowiedzi na to samo lub podobne pytanie. Odbiorcy, firmy medialne i organy regulacyjne nie znają skali problemu. Może się okazać, że firmy zajmujące się sztuczną inteligencją również tego nie wiedzą” – ocenia w raporcie BBC Pete Archer, programme director generative AI w BBC.

Ekspert dodaje, że użytkownicy „nie mogą polegać na asystentach AI w zakresie dostarczania dokładnych wiadomości i ryzykują wprowadzeniem w błąd”. „Aplikacje AI nie mają mechanizmu korygowania błędów, w przeciwieństwie do profesjonalnych serwisów informacyjnych, które własne pomyłki korygują”.

Zobacz: Google jak asystent AI? Gigant mocniej postawi na sztuczną inteligencję

W ocenie autorów opracowania media „powinni mieć kontrolę nad tym, czy i w jaki sposób ich treści są wykorzystywane, a firmy zajmujące się sztuczną inteligencją powinny pokazywać, w jaki sposób chatboty AI przetwarzają treści informacyjne wraz ze skalą i zakresem błędów i nieścisłości”. Jako możliwe rozwiązania problemu wskazano podjęcie partnerskiej współpracy firm AI z wydawcami mediów oraz adekwatne regulacje wykorzystywania sztucznej inteligencji.

“Sztuczna inteligencja przyniesie prawdziwą wartość, jeśli będzie używana w sposób odpowiedzialny. Ale sztuczna inteligencja niesie ze sobą również poważne wyzwania dla odbiorców i brytyjskiego ekosystemu informacyjnego” – podsumowauje Pete Archer z BBC.

Newsletter

Newsletter

TVN jednak nie na sprzedaż. Warner Bros. Discovery zmienia plan

TVN jednak nie na sprzedaż. Warner Bros. Discovery zmienia plan  Allegro odpowiada na "jedynkę" Temu. "Nasz koszyk zakupowy jest dwa razy większy"

Allegro odpowiada na "jedynkę" Temu. "Nasz koszyk zakupowy jest dwa razy większy"  Co z emisją naziemną Republiki i wPolsce24? Emitel zabrał głos

Co z emisją naziemną Republiki i wPolsce24? Emitel zabrał głos  Ogromny ekran, ruchomy stół. Tak prezentuje się nowe studio „Faktów” i TVN24

Ogromny ekran, ruchomy stół. Tak prezentuje się nowe studio „Faktów” i TVN24  Pięć rzeczy za które krytykowano trzeci sezon „Białego Lotosu”

Pięć rzeczy za które krytykowano trzeci sezon „Białego Lotosu”

Dołącz do dyskusji: AI myli liczby i stwierdzenia. To badanie pokazuje, że chatboty są dalekie od ideału