Apple będzie walczyć z dziecięcą pornografią, skanując zdjęcia użytkowników

Koncern Apple zapowiedział wprowadzenie nowych rozwiązań, które mają chronić dzieci przed obraźliwymi treściami i ograniczyć rozpowszechnianie dziecięcej pornografii. Niektóre z nich, w tym technologia skanująca zdjęcia użytkowników, budzą spore kontrowersje.

Zapowiedziane przez Apple rozwiązania, opracowane przez firmę wspólnie z ekspertami ds. bezpieczeństwa dzieci, koncentrują się na trzech obszarach: komunikacji, zdjęciach oraz wyszukiwaniu.

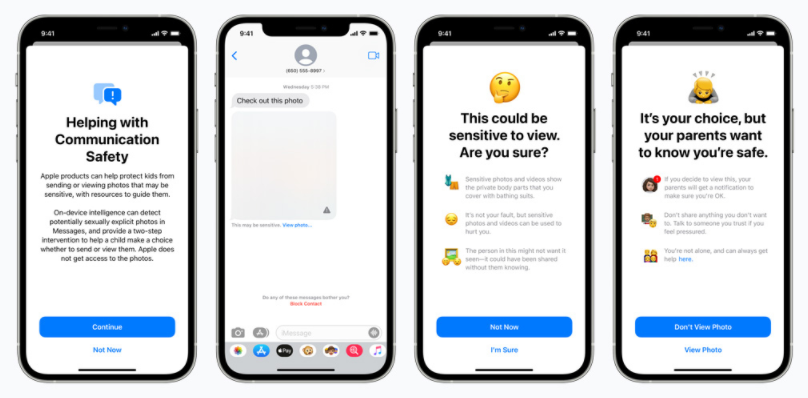

Pierwsze z nowych rozwiązań dotyczy aplikacji Wiadomości. Zastosowana zostanie w niej technologia uczenia maszynowego, dzięki której wychwytywane będą zdjęcia o charakterze seksualnym.

Gdy ktoś tego typu zdjęcie spróbuje przesłać nieletniemu użytkownikowi, zostanie on przed tym ostrzeżony, a także poinformowany, że jeśli mimo wszystko zdecyduje się na otwarcie załącznika, komunikat o tym fakcie otrzymają jego rodzice.

Podobna zasada będzie obowiązywała przy próbie wysłania przez dziecko zdjęcia zawierającego erotyczne treści, a więc najpierw ostrzeżenie, a następnie powiadomienie rodziców.

Drugie rozwiązanie dotyczy problemu rozpowszechniania treści zawierających pornografię dziecięcą, określanych skrótem CSAM (Child Sexual Abuse Material). Apple zamierza walczyć z tym zjawiskiem za pomocą technologii, która będzie wykrywać zdjęcia typu CSAM przechowywane w iCloud Photos.

Firma gwarantuje, że będzie to odbywać się z poszanowaniem prywatności użytkowników, gdyż zamiast skanować zdjęcia bezpośrednio w chmurze, system będzie to robił na urządzeniach. Wykorzystana zostanie tutaj baza tzw. hashów z informacjami referencyjnymi na temat zdjęć zawierających dziecięcą pornografię, które dostarczą organizacje zajmujące się ochroną praw dziecka. Apple przekształci tą bazę w zbiór niemożliwych do odczytania hashów, który zostanie umieszczony na urządzeniu. Skanowanie będzie się odbywać w momencie próby przesłania zdjęcia do iCloud Photos, przy użyciu technologii kryptograficznej "private set intersection", która nie ujawniając żadnej ze stron wyniku zweryfikuje czy wystąpiło dopasowanie. Takie zdjęcie trafi do iCloud Photos wraz z zakodowaną informacją o wyniku w postaci tzw. "safety vouchera".

Następnie do gry wchodzi kolejna technologia, "threshold secret sharing", dzięki której system uniemożliwi Apple dostęp do zawartości voucherów, o ile na danym koncie w iCloud Photos nie zostanie przekroczona określona liczba zdjęć typu CSAM. Ma to zapewnić wysoki poziom dokładności i skuteczności rozwiązania. Apple twierdzi, że dzięki temu szansa na nieprawidłowe oznaczenie dengo konta jako zawierającego treści z pornografią dziecięcą wyniesie mniej niż jeden do biliona rocznie.

Dopiero po przekroczeniu określonej liczby dopasowań, Apple będzie mogło zyskać dostęp do zawartości voucherów powiązanych z obrazami CSAM. Po weryfikacji przez swoich pracowników i potwierdzeniu wyniku, firma będzie blokować konto użytkownika i przesyłać informacje do odpowiednich organów. Od decyzji o blokadzie konta użytkownicy będą mogli się odwoływać.

Trzecie rozwiązanie obejmie asystenta głosowego Siri i wyszukiwanie treści w sieci. Tutaj Apple chce lepiej pomagać rodzicom i dzieciom w zachowaniu bezpieczeństwa online. Przykładowo, pytając Siri o możliwość zgłoszenia treści typu CSAM, użytkownik otrzyma konkretne wskazówki dotyczące tego gdzie i jak takie zgłoszenie złożyć.

Ponadto, Siri i Search będą interweniować gdy użytkownik będzie wyszukiwał treści powiązane z CSAM. W takim przypadku wyświetli się wyjaśnienie o szkodliwości i problematyczności, z jakimi wiąże się zainteresowanie danym tematem, wraz z odesłaniem do odpowiednich instytucji, które mogą udzielić pomocy w tym zakresie.

Apple zapowiedziało, że nowe rozwiązania zostaną wprowadzone pod koniec bieżącego roku w USA, jako aktualizacje do nowych wersji systemów firmy - iOS 15, iPadOS 15, watchOS 8 i macOS Monterey.

Koncern z Cupertino informuje, że przy pracach nad nowymi rozwiązaniami pod uwagę brane było przede wszystkim bezpieczeństwo użytkowników i ochrona ich prywatności. Firma zapewnia, że zostały one tak stworzone, aby nie miała ona bezpośredniego wglądu w prywatną komunikację użytkowników ani w ich zdjęcia.

Te zapewnienia nie wszystkich jednak przekonują. Wśród ekspertów pojawiają się opinie, że jest to zbyt duża ingerencja w prywatność użytkowników. Zwraca się też uwagę, że w przyszłości system może zostać rozszerzony o skanowanie innych treści, w tym takich, które będą mogły wywierać wpływ na bieżące wydarzenia.

W zeszłym kwartale finansowym Apple osiągnęło wzrost przychodów sprzedażowych netto o 36 proc. do 81,43 mld dolarów, a jego zysk netto poszedł w górę z 11,25 do 21,74 mld dolarów. Sprzedaż iPhone’ów zwiększyła się o 50 proc., a wpływy w Chinach - o 58 proc.

Newsletter

Newsletter

Jeden z kanałów Disneya zostaje tylko w trzech krajach. Wśród nich Polska

Jeden z kanałów Disneya zostaje tylko w trzech krajach. Wśród nich Polska  Wszystko, co wiadomo o piątym sezonie „Emily w Paryżu”

Wszystko, co wiadomo o piątym sezonie „Emily w Paryżu”  Telewizja wPolsce24 pokaże serial satyryczny o władzy

Telewizja wPolsce24 pokaże serial satyryczny o władzy  TOP 20 graczy na polskim rynku e-commerce. Allegro i Temu dzieli przepaść

TOP 20 graczy na polskim rynku e-commerce. Allegro i Temu dzieli przepaść  AppleTV+ już zapowiada seriale na lato. Co warto obejrzeć?

AppleTV+ już zapowiada seriale na lato. Co warto obejrzeć?

Dołącz do dyskusji: Apple będzie walczyć z dziecięcą pornografią, skanując zdjęcia użytkowników

Swoją droga to będzie całkiem ciekawe. Jak np. apple zakwalifikuje zdjęcia dzieci które „madki” wrzucają czasem na Facebooka ^^